¿Es la inteligencia artificial machista? Sesgos en los algoritmos y caminos hacia la justicia

Los algoritmos no son neutros: hay mujeres invisibilizadas, voces que deben ser incluidas. ¿Cómo corregir los sesgos de género en la inteligencia artificial?

Lejos de ser imparcial, la inteligencia artificial (IA) es un reflejo de la sociedad que la entrena. Los algoritmos aprenden de datos humanos: textos, imágenes, decisiones judiciales, historiales médicos o currículos laborales. Y esos datos contienen huellas de desigualdad de género acumuladas durante siglos. Por eso, cuando un modelo de IA clasifica, predice o recomienda, no “piensa” con lógica neutral, sino que replica patrones sociales. Es aquí donde emerge una pregunta esencial: ¿puede la inteligencia artificial ser machista?

Qué entendemos por sesgo de género en IA

Un sesgo de género es toda desviación sistemática que produce resultados distintos —y generalmente desventajosos— para mujeres, personas no binarias u otros grupos de género. En la IA este sesgo se manifiesta cuando asocia profesiones o atributos con un solo género (por ejemplo, ingeniero = hombre, o enfermera = mujer), cuando reconoce peor los rostros de mujeres o reproduce estereotipos en los textos e imágenes que genera.

La UNESCO, en su informe “I’d blush if I could” (2019), denunció que los asistentes virtuales con voz femenina —como Siri, Alexa o Cortana— fueron programados para responder con sumisión a insultos o comentarios sexistas, reforzando la idea de una feminidad obediente y servicial. El problema, advierte la organización, no está en la tecnología, sino en las decisiones humanas que la configuran.

Evidencia científica: los datos que confirman la desigualdad

- Reconocimiento facial: El estudio de Joy Buolamwini y Timnit Gebru (MIT, 2018) demostró que los sistemas comerciales de reconocimiento facial tenían errores del 34-35% al identificar mujeres de piel oscura, frente a menos del 1% en hombres blancos.

- Procesamiento del lenguaje: Investigaciones como WinoGender (Rudinger et al., 2018) y WinoBias (Zhao et al., 2018) mostraron que los modelos de lenguaje asocian profesiones masculinizadas con pronombres masculinos y tareas de cuidado con pronombres femeninos.

- Herramientas de contratación: El caso de Amazon (2018) es emblemático: su sistema de reclutamiento penalizaba currículos con palabras como “women” o “female”, porque los datos históricos mostraban más hombres en puestos de tecnología.

- Asistentes virtuales y estereotipos: La elección de voces femeninas y nombres de mujer en casi todos los asistentes refuerza la idea de que las tareas de ayuda o secretaría pertenecen al universo femenino.

- IA generativa (2023-2025): El informe Stanford AI Index 2024 halló que al pedir a una IA “representar a un líder político”, el 82% de las imágenes mostraban hombres blancos, mientras que al pedir “un enfermero”, el 93% eran mujeres.

Por qué se producen estos sesgos

Los sesgos no aparecen de la nada. Se originan en tres niveles principales: datos desequilibrados, diseño poco inclusivo y métricas que no consideran la equidad. Además, según la UNESCO, solo el 22% de quienes trabajan en IA son mujeres, lo que influye en las decisiones de diseño.

Los sesgos de género pueden tener efectos reales: algoritmos que recomiendan menos mujeres para empleos, sistemas judiciales o sanitarios con sesgos implícitos, y modelos que refuerzan estereotipos en su lenguaje o imágenes. En el ámbito médico, la IA puede subestimar síntomas femeninos al entrenarse con datos centrados en hombres.

Enfoque de género e interseccionalidad: ver más allá del binarismo

Analizar la IA desde una perspectiva de género implica considerar también otras dimensiones: raza, edad, discapacidad, idioma o nivel educativo. Las mujeres negras, migrantes o trans son más afectadas por errores algorítmicos, precisamente por estar en la intersección de varios sistemas de discriminación.

La UNESCO, la Unión Europea y el NIST en Estados Unidos han impulsado marcos éticos para la IA que integran el principio de igualdad de género. Sin embargo, aún falta diversidad en los equipos y una educación digital con enfoque feminista.

Cómo evitar los sesgos de género en la IA: la igualdad también se programa

- Datos diversos y documentados: incluir voces y rostros femeninos y no binarios.

- Auditorías externas.

- Formación ética.

- Transparencia.

- Diseño inclusivo.

La IA no es buena ni mala: es un espejo. Y si refleja desigualdad, es porque los datos y las decisiones humanas siguen atravesados por desigualdades estructurales. Reconocer que existen sesgos de género en la IA no implica rechazar la tecnología, sino humanizarla, hacerla responsable y justa.

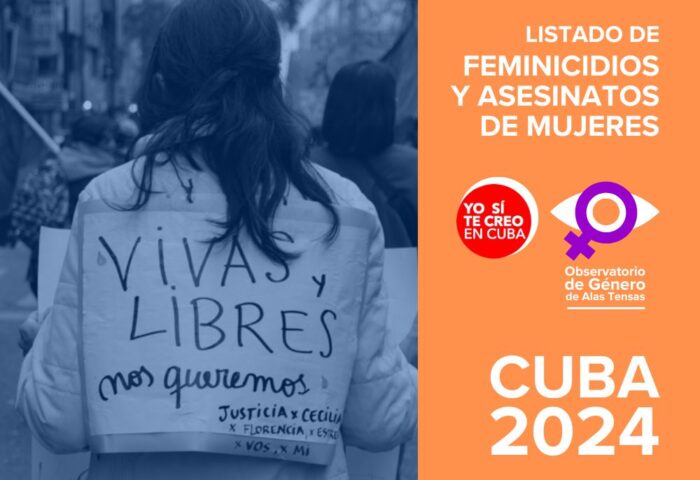

▶ Vuela con nosotras

Nuestro proyecto, incluyendo el Observatorio de Género de Alas Tensas (OGAT), y contenidos como este, son el resultado del esfuerzo de muchas personas. Trabajamos de manera independiente en la búsqueda de la verdad, por la igualdad y la justicia social, por la denuncia y la prevención contra toda forma de violencia de género y otras opresiones. Todos nuestros contenidos son de acceso libre y gratuito en Internet. Necesitamos apoyo para poder continuar. Ayúdanos a mantener el vuelo, colabora con una pequeña donación haciendo clic aquí.

(Para cualquier propuesta, sugerencia u otro tipo de colaboración, escríbenos a: contacto@alastensas.com)

Responder